澳门太阳城金琴教授团队1篇长文被WWW 2023录用

近日,澳门太阳城金琴教授团队AIM3多媒体计算实验室1篇长文《CapEnrich: Enriching Caption Semantics for Web Images via Cross-modal Pre-trained Knowledge》被国际万维网会议WWW录用。WWW(Proceedings of the ACM Web Conference 2023,国际万维网会议)是中国计算机学会(CCF)推荐的A类国际学术会议。本届会议的论文录用率为19.2%。

论文第一作者是来自AIM3多媒体计算实验室的2020级硕士生姚林丽,所有作者均为我校师生。

论文题目:CapEnrich: Enriching Caption Semantics for Web Images via Cross-modal Pre-trained Knowledge

作者:姚林丽,陈玮婧,金琴

通讯作者:金琴

论文概述:

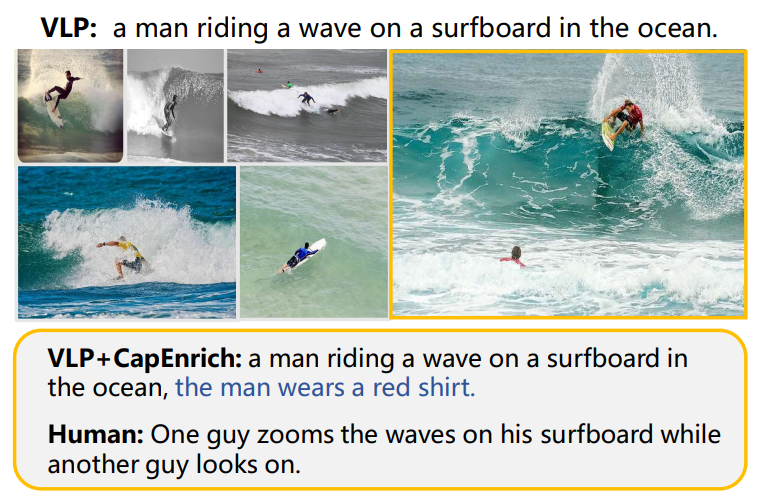

自动为互联网上的大量无标签图像生成文本描述,可以有效辅助多模态检索、推荐等实际应用。然而,现有模型普遍存在生成文本过于“笼统(over-generic)”的问题,即它们倾向于为不同的图像生成雷同甚至重复的简单句子。最先进的基于视觉-语言预训练的模型也无法避免该问题,例如上图中,VLP模型为6张图片生成相同的句子“a man riding a wave on a surfboard in the ocean”。考虑到互联网上图像的多样性,这些笼统的文本不能提供充分的语义信息。本文的目标是自动为图像生成包含更多视觉细节的文本。

基于先进的跨模态预训练(VLP)模型,我们提出了一个即插即用的框架CapEnrich,来利用VLP模型在预训练阶段学习到的丰富的视觉-文本概念对齐知识,自动为笼统的文本补充更多细节,无需人工标注富含细节的文本。具体地,我们首先提出了一个自动数据构造策略,来获得“先整体概括,再细节补充”的新格式文本,用于后续训练。然后我们结合提示学习(prompt learning),设计了手工提示模板和可学提示向量,来激励预训练模型生成更加细节的描述内容。在提示向量训练过程中,我们固定预训练模型参数、只更新提示向量,来保证两个优势:1)尽可能保留预训练模型的原有参数空间和预训练知识;2)轻量的参数学习,对低数据量的训练场景友好。在不同的预训练模型和数据集上的实验,证明了我们方法的通用性和有效性。

作者简介:

姚林丽,澳门太阳城2020级硕士,计算机应用技术专业,主要研究方向是视觉语言理解与生成。

金琴,中国澳门太阳城计算机系教授,多媒体计算实验室(AIM3)负责人。主要研究领域为多媒体智能计算、人机交互。